Was, wenn du eine Zielgruppe „befragen“ könntest, bevor du überhaupt ein Panel rekrutierst?

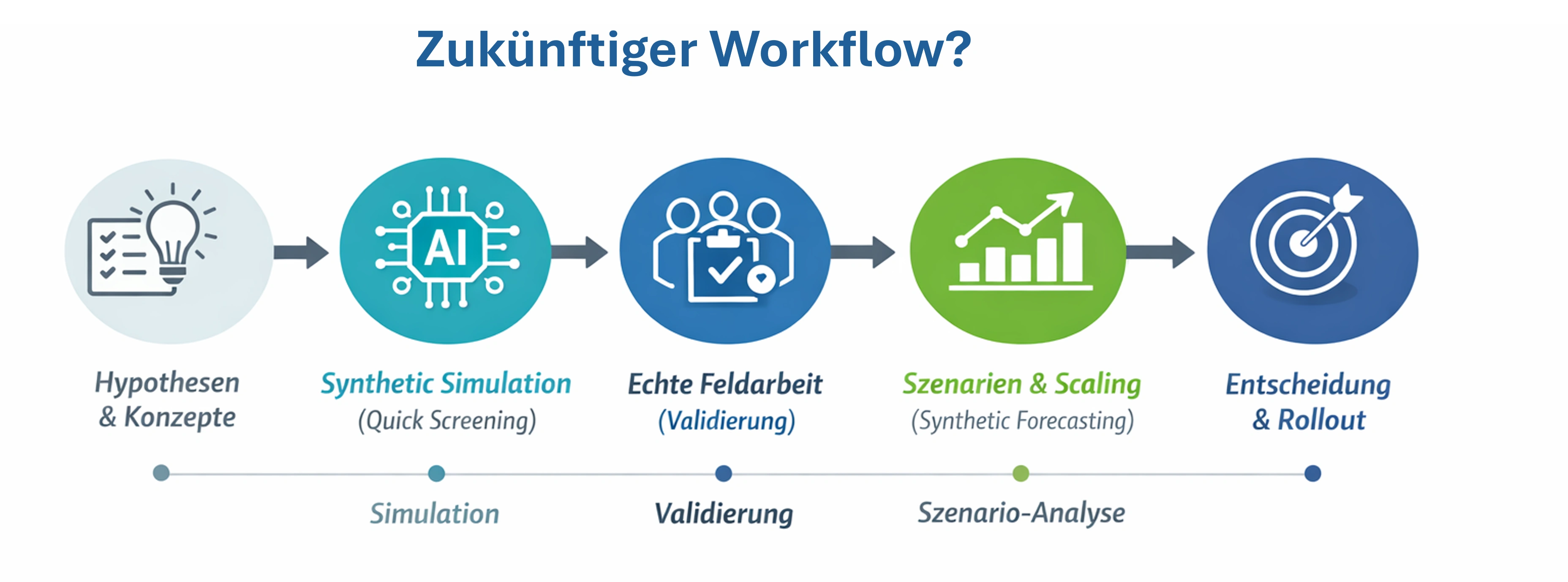

Genau das passiert gerade in vielen Insight-Teams: Synthetic Respondents und Synthetic Personas – also KI-gestützte, modellierte Zielgruppen – werden zunehmend als Simulationslayer genutzt. Nicht als Ersatz für echte Menschen, sondern als Turbo für Iterationen: schneller testen, besser priorisieren, weniger teure Fehlstarts.

Der Trend hat Rückenwind: Einige Researcher erwarten, dass synthetische Antworten in wenigen Jahren einen großen Teil der Datenerhebung ergänzen – teils sogar dominieren.

Was könnte da dran sein?

Was sind Synthetic Respondents eigentlich?

Stell dir Synthetic Respondents nicht als „Fake-Befragte“ vor, sondern eher wie einen Flugsimulator für Entscheidungen.

Ein synthetic respondent ist ein KI-Modell, das Antworten generiert, die sich statistisch und sprachlich ähnlich verhalten wie eine definierte Zielgruppe. Die Basis dafür sind reale Datenmuster: historische Befragungsdaten, Trackingdaten, Segmentdaten, Kaufverhalten oder andere valide Quellen.

- Was sie sind: ein Simulationsmodell für schnelle Hypothesen-Checks

- Was sie nicht sind: ein Ersatz für echte Exploration, kulturelle Überraschungen oder “neue Wahrheit” aus dem Feld.

Gerade Anbieter und Datenfirmen betonen: Der Wert entsteht nur, wenn Modelle sauber kalibriert und validiert werden – sonst ist es nur eine Maschine für plausible Antworten.

Warum dieser Trend jetzt Fahrt aufnimmt

Es braut sich eine typische „Perfect Storm“-Situation zusammen:

- Research muss schneller werden. Produktteams iterieren wöchentlich, Insights hängen oft am Feld.

- Panels werden teurer und schwieriger. Mehr Screening, mehr Fatigue, mehr Qualitätsstress.

- KI ist im Research-Stack angekommen. Automatisierung ist nicht mehr nice-to-have, sondern Standard.

Das Ergebnis: Synthetic Research könnte attraktiv als Zwischenstufe zwischen Idee und Feld sein – ein Layer, der Entscheidungen beschleunigt, bevor man große Budgets bewegt.

Wo Synthetic Respondents stark sind

Du hast 16 Ideen, 4 Tonalitäten und 2 Bildwelten?

Statt direkt ins Feld zu gehen, kannst du in Stunden eine synthetische Simulation laufen lassen:

- Welche Claims scheinen bei Segment A am stärksten?

- Welche Tonalität irritiert?

- Welche Konzepte wirken austauschbar?

Das ersetzt nicht das Feld – aber es hilft dir, die besten Kandidaten auszuwählen, bevor du echte Befragte „verbrätst“.

Trainingsaufwand ist der Preis für Geschwindigkeit

Ziel: Ein erster Prototyp, der grob plausibel antwortet. Dafür nutzt man:

- historische methodische Twin-Studien

- U&A- oder Segmentdaten

- Panels, Tracking, CX-Daten

- vorhandene Personas + Verhaltensdaten

Ergebnis: „Es könnte funktionieren“-Proof of Concept.

Hier muss das Modell:

- regionale Sprache & Codes abbilden

- Marke/Kategorie-Spezifika verstehen

- Antwortmuster realistisch darstellen (inkl. Varianz, nicht nur glatte Mittelwerte)

Ergebnis: Synthetic Respondents, die sich wie eine echte Zielgruppe verhalten.

Der Punkt, an dem sich entscheidet, ob es „Insight Tech“ ist oder „Fancy Nonsense“.

Typisch sind Tests wie:

- real vs. synthetisch (Holdout-Designs)

- Vergleich der Verteilungen, nicht nur der Means

- Segmentstabilität, Bias-Check

Genau diese Validierung wird in Industry-Beiträgen als Pflichtteil beschrieben, weil synthetische Daten sonst „zu sauber“ oder „zu glatt“ werden können.

So wird Synthetic Research ein Vorteil (oder ein Risiko)

DON’T

DO

Fazit: Synthetic Respondents verändern nicht den Zweck von Research – sondern könnten die Taktung verändern.

Der große Shift ist nicht: „KI ersetzt Menschen.“

Der Shift wäre: Research bekommt eine Simulationsebene, die Teams schneller lernen lässt.

Das Versprechen: Wer Synthetic Respondents als Iterationsmaschine versteht – mit klaren Leitplanken, Validierung und Hybrid-Design – gewinnt Geschwindigkeit, ohne die Realität zu verlieren.

Und genau das macht den Trend so spannend: Er ist kein Hype. Er ist ein neues Stück Infrastruktur im Insight Tech Stack.

WANTED

AIDVISOR sucht noch einen Partner für einen Piloten - Wer hat Interesse?