Agentic AI

Die Signale sind eindeutig: Agentic AI ist nicht mehr nur ein „Buzzword“, sondern eine neue Produktlogik.

Und genau deshalb lohnt sich ein genauer Blick – auch kritisch.

Was sind „Agents“ im Kontext von CX & Insights?

Ein klassisches CX-/Insight-Setup funktioniert wie ein Kontrollzentrum:

- Daten rein (Surveys, Reviews, Calls, CRM, Social)

- Analyse & Dashboard raus

- Und dann: Menschen entscheiden & handeln.

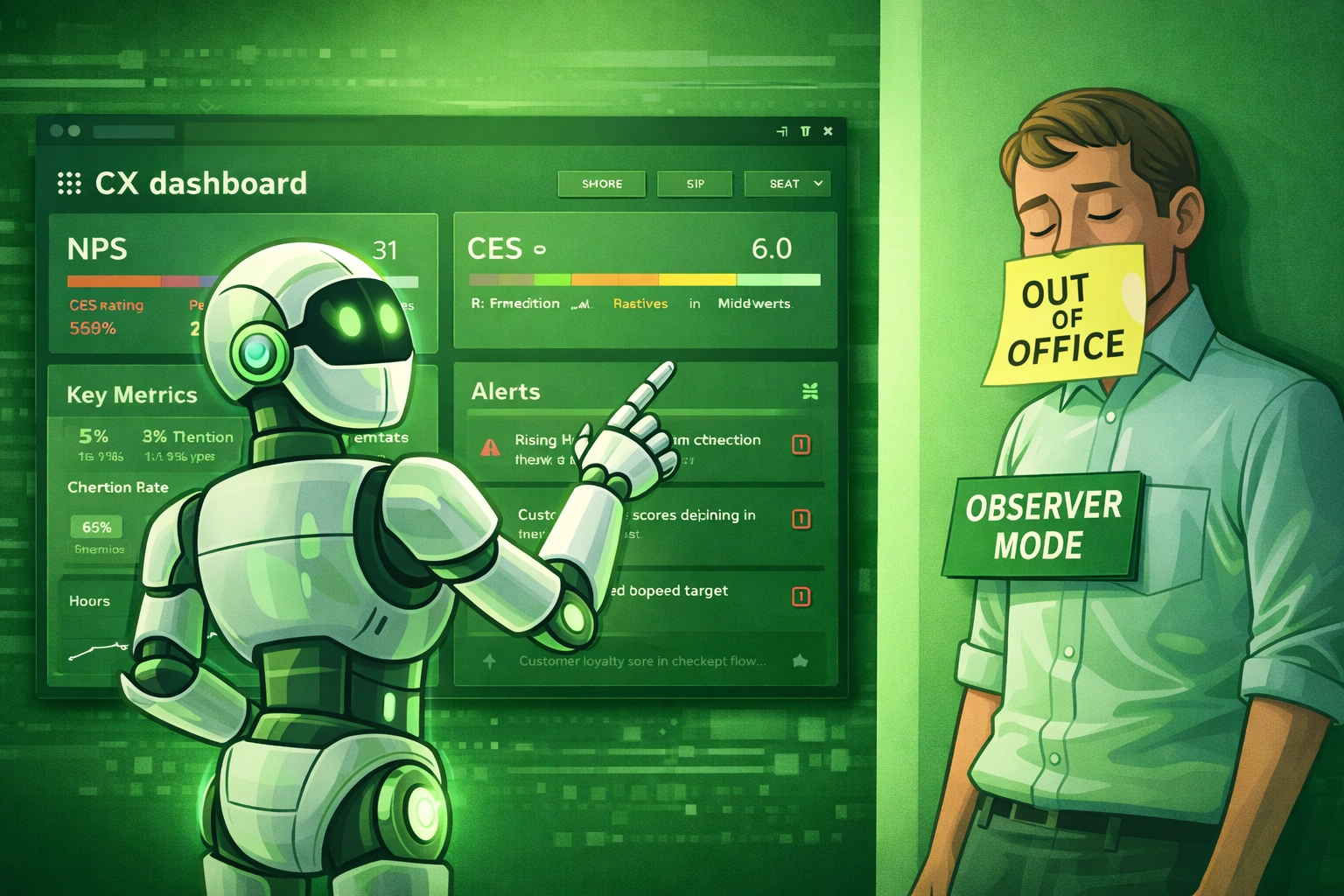

Agentic AI dreht dieses Modell um:

Der „Agent“ wird zum aktiven Akteur im System.

Experience Agents – wie Qualtrics sie beschreibt – sind AI-gestützte, autonome Einheiten, die direkt mit Kunden oder Mitarbeitenden interagieren können, um Erfahrungen zu verbessern.

In einfachen Worten: Das System bleibt nicht beim Insight stehen – es greift ein.

Welche Tasks werden autonom?

Der Sprung von „Analytics“ zu „Agents“ entsteht vor allem durch drei autonome Aufgabenbereiche:

1) Themen erkennen & clustern

Agents bündeln offene Antworten automatisch, erkennen Muster und priorisieren Themen – schneller als jedes Insight-Team es könnte.

2) Alerts & Frühwarnsysteme

Statt monatlichem Reporting entstehen Realtime Signale:

- steigende Frustration im Checkout

- neue Treiber für Abwanderung

- Service-Probleme in einer Region

Qualtrics skizziert hier Szenarien, in denen Agenten Verhaltenssignale wie „digital frustration“ erkennen und proaktiv reagieren.

3) Action Recommendations & sogar Actions

Das ist der eigentliche Gamechanger:

Der Agent schlägt nicht nur vor („Customer unhappy, please respond“), sondern antwortet im richtigen Ton, bietet Kompensation, stellt Rückfragen – und triggert ggf. Workflows.

Damit wird ein Feedback-Kanal plötzlich zum Service-Kanal.

Warum das spannend ist (und warum es gefährlich werden kann)

Agentic AI löst ein echtes Problem:

Insight Teams sitzen oft zwischen Daten und Handlung – die Umsetzung hängt in der Organisation fest. Agents versprechen:

- kürzere Feedback-Loops

- weniger Zeitverlust

- höhere Reaktionsgeschwindigkeit

- skalierbare Personalisierung

Aber genau hier beginnt auch die kritische Zone.

Warum wurde genau diese Aktion ausgelöst? Und warum nicht eine andere?

Das Problem: Viele Agent-Systeme geben Entscheidungen nicht wirklich „auditierbar“ aus. Man sieht, dass etwas passiert – aber nicht sauber, warum, basierend auf welchen Signalen, und mit welcher Unsicherheit.

In CX ist das brandgefährlich:

Ein falsch getriggertes Incentive, eine unpassende Entschuldigung oder eine eskalierende Kommunikation kann mehr Schaden als Nutzen erzeugen.

Agentic AI ist stark darin, Signale zu erkennen – aber nicht automatisch darin, Relevanz im Business-Kontext zu verstehen.

Typisches Muster:

- Der Agent reagiert auf viele Beschwerden (laute Minderheit)

- aber übersieht stille Kündiger (Abwanderung ohne Feedback)

- oder priorisiert Themen, die „emotional“ wirken, statt geschäftskritisch zu sein.

Das ist nicht die Schuld der AI – das ist ein Designproblem:

Ohne klare Ziele, Gewichtungen und Leitplanken optimiert der Agent für das Falsche.

Früher musste ein Mensch handeln. Fehler waren begrenzt.

Heute:

Ein Agent kann falsch handeln – und zwar tausendfach, sofort, automatisch.

- Was als Effizienz beginnt, kann in der Fläche plötzlich zur Governance-Frage werden:

- Wer haftet für falsche Kommunikation?

- Wer kontrolliert Tonalität?

- Wer überprüft, ob Maßnahmen diskriminieren oder Gruppen benachteiligen?

Die Transformation ist real – aber sie macht CX nicht nur schneller.

Sie macht es risikoreicher, wenn man sie nicht sauber kontrolliert.